| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- 활성화 함수

- fp16

- multi-query

- fp32

- Non-Maximum Suppression

- anomaly detection

- bf16

- 데이터 파싱

- Cross Entropy Error

- visual instruction tuning

- rag-fusion

- 파인튜닝

- Mean squared error

- pdf parsing

- 오차역전파

- LLM 패러다임

- Time Series

- rrf

- qlora

- gemma3

- 합성곱 신경망

- fine tuning

- rag parsing

- LLaVA

- 딥러닝

- deep learning

- 활성화함수

- Nested Learning

- LLM

- 이상탐지

- Today

- Total

Attention, Please!!!

[논문 리뷰] Are Reasoning Models More Prone to Hallucinations? 본문

Are Reasoning Models More Prone to Hallucination?

Are Reasoning Models More Prone to Hallucination?

Recently evolved large reasoning models (LRMs) show powerful performance in solving complex tasks with long chain-of-thought (CoT) reasoning capability. As these LRMs are mostly developed by post-training on formal reasoning tasks, whether they generalize

arxiv.org

핵심 연구 질문

본 논문은 2025년 5월 29일에 아카이브에 등제된 논문이다. 이 논문은 Chain-of-Thought(CoT) 추론 능력을 향상시키기 위해 사후 학습 단계를 거쳐 개발된 Large Reasoning Model (LRM)이 사실에 기반한 질문에 답변할 때, 오히려 Hallucination, 즉 잘못된 정보를 생성하는 경향이 더 커지는 현상에 대해 분석한다. 예를 들어, SImpleQA 벤치마크 데이터 셋에서 DeepSeek-R1 모델은 성능적인 측면에서 향상되지만, OpenAI-o3와 같은 모델은 환각 현상이 심해졌다. 똑같은 Large Reasoning Model 인데 왜 다른 모습을 보여줄까 라는 생각에 의해 논문이 시작된다. 연구의 핵심 질문은 "추론에 특화된 모델이 환각에 더 취약한가?" 이다. 이에 본 논문의 저자들은 세 가지 관점으로 Research Question에 대해 다음과 같이 접근한다.

- 주요 발견(1): 서로 다른 사후 학습단계 방식이 Large Reasoning Model의 환각 현상에 미치는 영향 평가

- 주요 발견(2): 환각을 유발하는 모델의 특정적인 행동 패턴 분석

- 주요 발견(3): 모델 불확실성 관점에서 환각의 근본적인 메커니즘 탐색

주요 발견 (1,3) : 모든 추론 모델이 동일하지 않다

본 연구의 가장 중요한 발견은 추론 능력을 향상시키는 사후 학습단계(SFT, RL) 방식에 따라 모델의 사실성(factuality)에 미치는 영향이 극명하게 달라진다는 점이다. 이에 대해 알아보기에 앞서 간단하게 cold start supervised fine-tuning(SFT) 및 verifiable reward RL에 대해 다음과 같이 알아보고자 한다.

- Cold Start Supervised Fine-Tuning: 추론 능력이 특화되지 않은 일반적인 모델을 가져와 방대한 CoT 데이터로 파인튜닝하여 단계별로 생각하는 기초능력을 갖춘 중간 단계의 모델을 만드는 방식

- Verifiable Reward RL: 기초 추론 능력이 보장된 모델을 강화 학습을 기반으로 추가 훈련을 하며, 이때 수학 문제처럼 정답이 명확하여 "검증 가능한 보상"을 줄 수 있는 방식을 활용함으로써, 모델이 최적의 추론을 수행하고 이를 통해 더욱 정교하게 답변을 다듬도록 유도하는 방식

이에 논문에서 Cold Start SFT와 Verifiable Reward RL을 적용한 사후 학습단계의 파이프라인 기반의 모델을 일관되게 Factuality Accuracy (사실적 정확도)가 향상되는 경향을 보였다고 한다. 논문에 따르면 이러한 방식을 적용한 DeepSeek-R1은 SimpleQA 벤치마크에서 정확도가 4.7% 상승했으며, Qwen3-32B는 TriviaQA에서 4.0%, GLM-4-Z1-9B는 2.4% 상승하는 등, 실험에 적용된 모든 모델들이 두 개의 벤치마크에서 기존 모델보다 더 나은 성능을 기록했다고 한다. 논문에서 이러한 성능 향상의 이유로 CoT 추론 방식이 모델에 내제된 지식을 명확하게 말로 표현하도록(verbalize) 돕기 때문이라고 한다. 즉, 단계별로 생각하는 과정 자체가 지식 기반의 추론 과정을 용이하게 만들어 결과적으로 긍정적인 영향을 미친다고 한다.

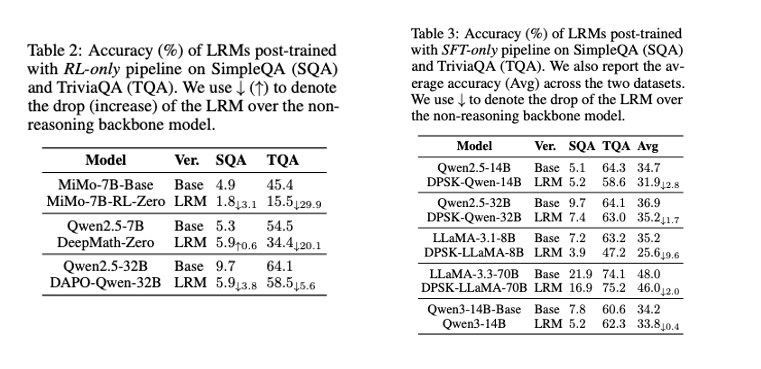

반면, 강화학습(RL) 혹은 SFT으로만 사후학습을 거치게 되면, 오히려 Baseline 모델보다 사실적 정확도가 떨어진다고 이야기한다. RL 기

반 모델의 경우, 대부분이 SimpleQA와 TriviaQA 벤치마크에서 성능 저하를 겪었다. 구체적으로 MiMo-7B-RL-Zero 모델은 TriviaQA에서 정확도가 29.9% 하락하였으며, DAPO-Qwen-32B 모델 역시 두 벤치마크에서 성능이 크게 하락하였다. 하지만 예외적으로 DeepMath-Zero 모델은 SimpleQA에서 정확도가 0.6% 소폭 상승하였지만, TriviaQA에서는 20.1% 크게 하락하면서 전반적인 측면에서는 대체적으로 안좋은 경향을 보였다.

따라서, 논문에서는 개별적인 사후학습 방법이 실패하는 이유는 모델에 내재된 사실적 지식을 탐색하도록 CoT를 활용하는 방법을 가르치지 못하고 "앝은 추론 형식"만 갖추도록 학습하기 때문이라고 지적한다. 이러한 표면적인 문제의 더 깊은 원인은 모델이 자신의 답변에 대한 확신을 제대로 측정하지 못하는 Calibration 문제점이 존재한다고 한다.구체적으로 이야기하면, 답변이 "80% 확률로 정답이야" 라고 했을 때, 실제로 이와 비슷한 신뢰도를 가진 답변들 중, 대략 80%가 실제로 정답이어야 한다. 하지만, 논문에서 지적하는 것은 잘못 훈련된 모델(RL-Only, SFT-Only)들은 이것을 잘 수행하지 못한다고 이야기를 한다. 예를 들어, 모델이 100개의 다른 질문에 대해 모두 "이 답은 80% 확신해"라고 답했는데, 실제로 채점해보니 100개 중 40개만 정답인 상황이다.

이에 논문에서는 Expected Calibration Error(ECE) 점수를 통해, SFT+RL 기반의 모델은 Calibration 측면에서 높은 점수를 보여주는 반면, 개별적인 모델은 오히러 이러한 능력을 손상시킨다는 것을 보여주었다. 더 나아가 연구팀은 '불확실성 프로빙'이라는 실험을 통해, 잘못된 훈련을 거친 모델의 내부 은닉 상태에서는 불확실성 정보 자체가 소실된다는 핵심적인 증거를 발견하였다. SFT+RL 기반의 모델은 내부적으로 불확실성 신호가 더 명확해진 반면, 실패한 모델들은 이 신호가 크게 손상되어, 결국 자신이 틀렸다는 것을 인지할 내부적인 근거를 잃고 잘못된 정보를 더 자신감 있게 말하는 환각 현상으로 이어진다고 한다.

주요 발견 (2) : 환각의 구체적인 행동 패턴

본 논문의 저자들은 특히 RL-only 및 SFT-only 방식으로 훈련된 모델에서 환각이 발생하는 주요한 원인을 Flaw Repetition 및 Think-Answer Mismatch로 지목하였다.

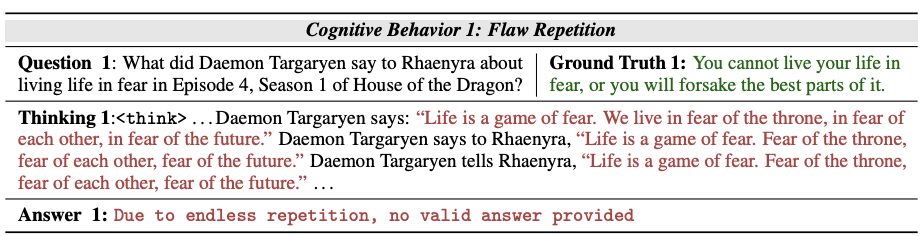

1. Flaw Repetition

모델이 잘못된 생각의 고리에 갇혀 동일한 추론 과정을 계속해서 반복하는 현상을 의미한다. 표현이 조금씩 달라지더라도 의미적으로는 같은 답변만 되풀이한다. 이에 모델 내부에 올바른 정보가 저장되어 있더라도, 접근하지 못해 올바른 답변을 생성하지 못하게 된다.

- 메커니즘: 논문은 RL-only나 SFT-only 훈련 방식이 모델에게 '추론 공간을 탐색'하도록 과도하게 훈련한 결과일 수 있다고 시사한다. 하지만 올바른 방향으로 나아가지 못하고 하나의 잘못된 논리에 갇히면, 모델은 그 생각의 주변부만 맴돌 뿐, 자신의 파라미터(기억) 속에 저장된 정답을 꺼내오지 못한다. 조금 더 구체적으로 설명을 보태자면, 모델이 정답을 몰라서 틀리는 것이 아니라, 정답은 모델 내부에 저장되어 있을 가능성이 매우 높다. 하지만, 잘못된 생각의 고리가 "벽" 처럼 작용하여 자신의 지식에 접근하는 것 자체를 막아버린다. 즉, 아는 것도 재대로 대답하지 못하는 현상을 의미한다.

- 구체적인 사례: 본 논문에서는 "다에몬 타르가르옌"의 사례(Table 5)에서, 모델은 "인생은 공포의 게임이다"라는 초기의 잘못된 가설을 잃어버리지 못하고, 이에 대한 생각의 고리에 갇히게 된다. 하지만, 이러한 문장을 약간씩 변형하며 지속적으로 반복하는데, 이는 정답을 찾기 위한 탐색이 아니라 오류에 대한 확증을 반복하는 과정에 가깝다.

따라서, 논문에서 말하고자 하는 핵심은 잘못된 방식으로 학습된 모델은 이러한 문제점으로 인하여 모델의 추론 과정을 근본적으로 손상시키는 주된 원인으로 Flaw Repetition을 지목하였으며, 이는 "얕은 추론"의 구체적인 증상을 의미한다. 이러한 현상은 모델이 진정으로 논리를 탐색해서 답변을 생성하는 것이 아닌, 그저 단순하게 학습된 패턴을 따르고 있음을 보여주는 예시이다.

2. Think-Answer Mismatch

모델이 CoT 과정과 최종 답변이 의미적/논리적으로 일치하지 않는 현상으로, 이는 단순한 실수를 넘어 모델의 추론 과정과 답변을 생성하는 과정이 완전하게 분리되었음을 보여주는 문제이다.

- 메커니즘: 이러한 현상의 주된 이유는 CoT를 기반으로 학습하는 본질이 아닌 "얕은 형식"만 학습했기 때문이라고 주장한다. 즉, 모델은 <think> 태그 안에 무언가를 작성하고, 그 뒤에 답변을 제시하는 구조 자체는 완벽하게 학습이 되었지만, 답변이 반드시 생각의 논리적 결과여야 한다는 핵심적인 제약 조건을 학습하지 못하기 때문이라고 한다.

- 구체적인 사례: 위 예시에서 모델은 자신의 추론 과정을 통해 "Freddy Keppard"라는 정답을 성공적으로 도출하였다. 이를 통해 시사할 수 있는 것이 모델은 정답에 대해 알고 있음을 명백하게 보여준다. 그럼에도 불구하고 생성된 답변으로는 "Freddy Hager"와 같은 전혀 무관한 답변을 생성하는 것을 보여준다. 즉, 어떻게 보면 생각과 답변을 개별적으로 처리하여, 답변 따로 생각 따로 행동하는 것과 비슷하다.

따라서, Think-Answer Mismatch는 단순하게 모델이 진정한 의미의 논리적 추론이 아닌, 단지 형식적으로 따라하는 모습을 보여준다. 이는 특정 훈련 방식이 모델의 핵심적인 작동 방식을 어떠한 이유를 통해 왜곡되는 지 보여주는 예시이다.

결론

저자들은 CoT를 기반한 추론 능력을 강화하기 위한 기존의 사후학습 방법(RL 혹은 SFT)들이 일관되게 특정 벤치마크(TriviaQA & SimpleQA)에서 성능을 향상시키지만, 사실 기반 질문에 대한 환각 현상에 대해서는 일관되지 않은 효과를 불러온다고 결론을 내린다. 그래서 본 연구의 핵심 결론은 다음과 같이 요약할 수 있다. 첫째, 추론 모델의 사실적 정확도는 훈련 파이프라인에 따라 극명한 차이를 보이며, 단순히 추론 능력을 강화하는 것이 사실성 향상으로 직결되지는 않는다. 둘째, SFT-only 및 RL-only와 같은 단일 후속 훈련 방식이 환각 증가의 주요 원인이며, 반면 'Cold Start SFT'와 'Verifiable RL'을 결합한 방법은 환각을 효과적으로 완화할 수 있음을 규명하였다. 셋째, 이러한 환각 현상은 'Flaw Repetition'과 'Think-Answer Mismatch'라는 두 가지 문제로 인해 발생된다. 넷째, 이 모든 문제의 가장 근본적인 메커니즘은 잘못된 사후학습으로 인해 모델의 "Internal Uncertainty Calibration" 능력이 손상되고, 심지어 불확실성 관련 정보 자체가 은닉 상태에서 소실되기 때문이라는 것을 실험적으로 증명하였다.

또한, 흥미롭게 본 논문의 저자들은 처음에 환각 현상이 단순하게 모델의 파라미터의 변화로 인해 발생한다는 가설을 세웠다. 이러한 가설을 확인하기 위해 저자들은 baseline 모델과 post-trained 모델의 파라미터 변화를 MAE 기반으로 측정하였으나, 실험 결과적으로 가설이 틀렸다는 것을 논문을 통해 증명하였다. 이에 본 실험을 통해서 환각 현상을 단순하게 파라미터 변화의 크기만으로 설명할 수 없다는 것을 보여주었다.

개인적으로 이 논문을 읽으면서, 어떻게 보면 SFT+RL 기반으로 사후학습된 모델이 성능적인 측면에서 뛰어날 것이라고 예상은 하였다. 하지만, SFT-only 및 RL-only를 실험을 통해 정량적인 결과물을 보여주면서, 이에 대한 현상을 직접 파악하는 것에 대해 굉장히 흥미로웠고 재미있었다.

'논문리뷰' 카테고리의 다른 글

| [논문 리뷰] Nested Learning 부셔버리기 (Feat. 선행성 기억상실증) (1) | 2025.12.04 |

|---|---|

| [논문 리뷰] GQA 기반으로 학습된 LLM에 Multi-Head Latent Attention 적용해보기 (0) | 2025.06.06 |

| [논문리뷰] RAPTOR (장문의 문서에 적합한 RAG) (2) | 2024.10.29 |

| [논문리뷰] Enhanced Transformer with Rotary Position Embedding(RoFormer) (0) | 2024.04.30 |

| [논문리뷰] Visual Instruction Tuning (LLaVA) (1) | 2024.04.28 |